あわせて読みたい

Dify: 最先端のAgentic AI開発プラットフォーム

DifyでAgentic AIの可能性を解き放ちましょう。あらゆる規模のチームに向けて、自律型エージェント、RAGパイプライン、その他の機能をスムーズに開発、デプロイ、管理でき...

目次

ローカル環境で動かすメリット

- セキュリティ管理

- カスタマイズの自由度

- 環境設定やモデルの詳細な調整が可能

- 必要に応じてソースコードの修正も可能

- コスト管理

- クラウド利用料金の削減

- リソース使用量の直接的なコントロール

- 開発効率

- ローカルでの即時デバッグが可能

- 開発サイクルの短縮

Dockerセットアップ手順

1. リポジトリのクローン

プロジェクトディレクトリにて公式のリポジトリをクローンします

git clone https://github.com/langgenius/dify.git .

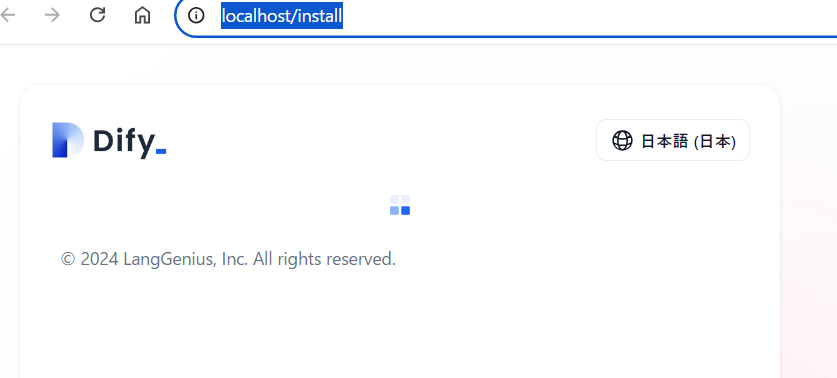

2. Docker起動

cd .\docker\

docker-compose up -d

Dockerのリソース制限 初回起動時のコンテナビルド処理でロードに時間がかかる場合あります

↓

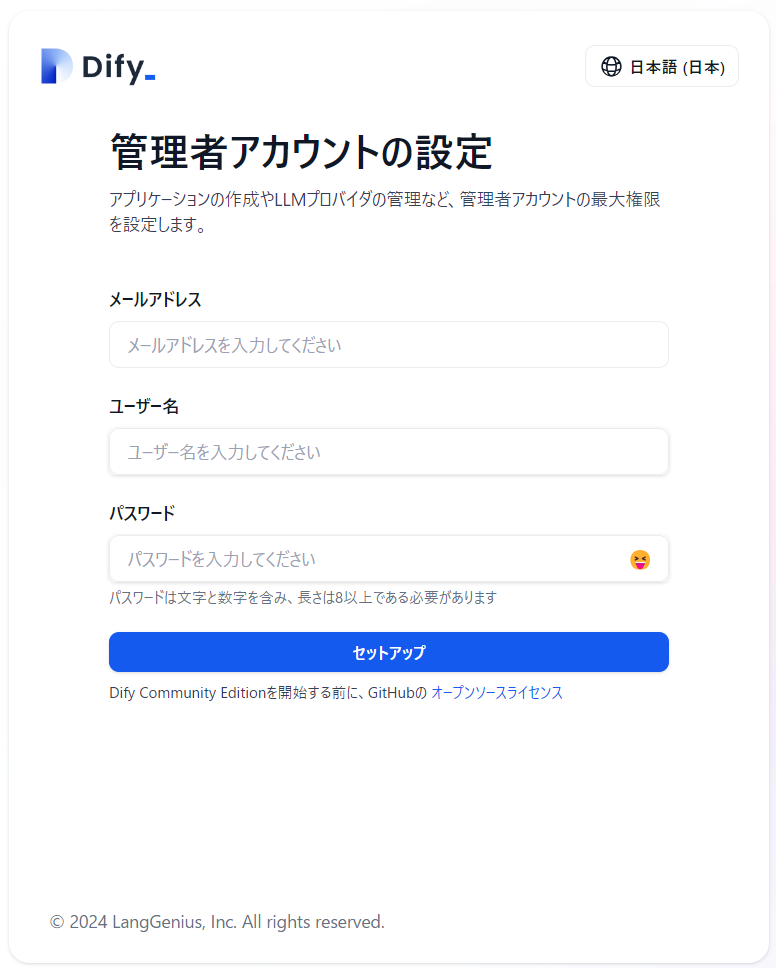

まずは、test@test.comなどのテストアカウントで設定を進め、基本的な動作を確認することをお勧めします。その後、必要に応じて実際のメールアドレスに変更することもできます。

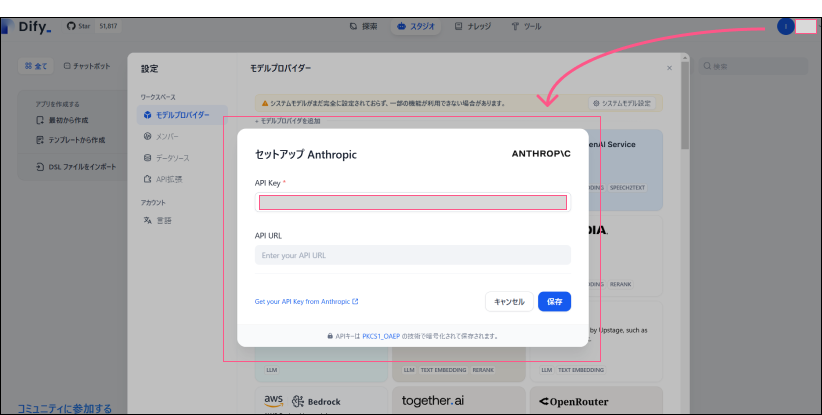

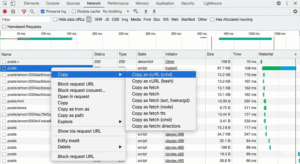

Dify での OpenAI の設定

「設定」→「Model Provider」

APIキーのみを入力

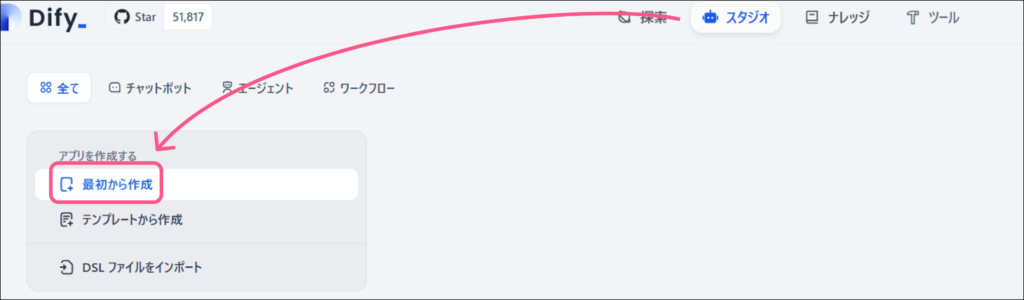

チャットボット作成

Web公開

「公開する」から「ウェブサイトに埋め込む」で下記の通りWeb上にアップできます

注意)Docker起動しておかないと接続はできません