Contents

ローカル環境で動かすメリット

- セキュリティ管理

- 機密データや会社の情報をローカルで完全に管理可能

- カスタマイズの自由度

- 環境設定やモデルの詳細な調整が可能

- 必要に応じてソースコードの修正も可能

- コスト管理

- クラウド利用料金の削減

- リソース使用量の直接的なコントロール

- 開発効率

- ローカルでの即時デバッグが可能

- 開発サイクルの短縮

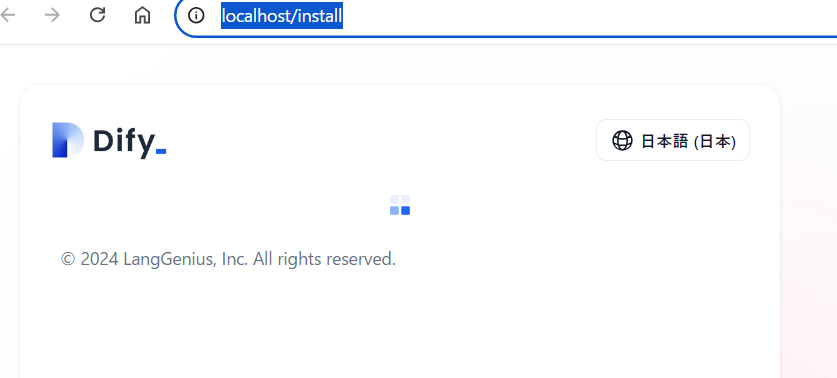

Dockerセットアップ手順

1. リポジトリのクローン

プロジェクトディレクトリにて公式のリポジトリをクローンします

git clone https://github.com/langgenius/dify.git .2. Docker起動

cd .\docker\

docker-compose up -d

Dockerのリソース制限 初回起動時のコンテナビルド処理でロードに時間がかかる場合あります

↓

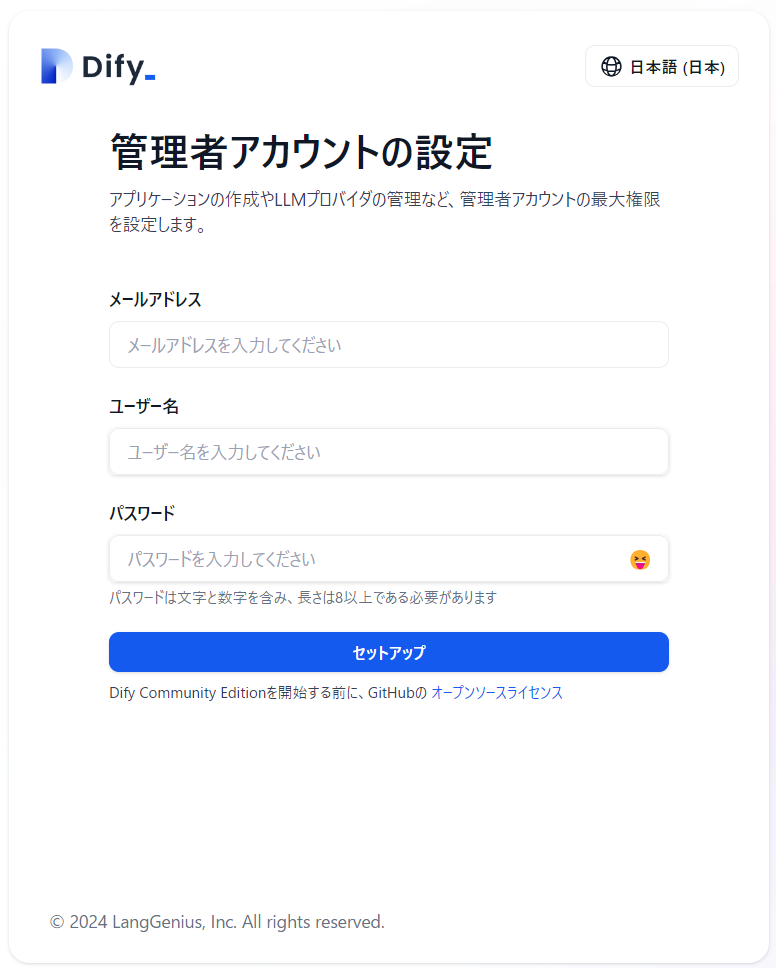

まずは、test@test.comなどのテストアカウントで設定を進め、基本的な動作を確認することをお勧めします。その後、必要に応じて実際のメールアドレスに変更することもできます。

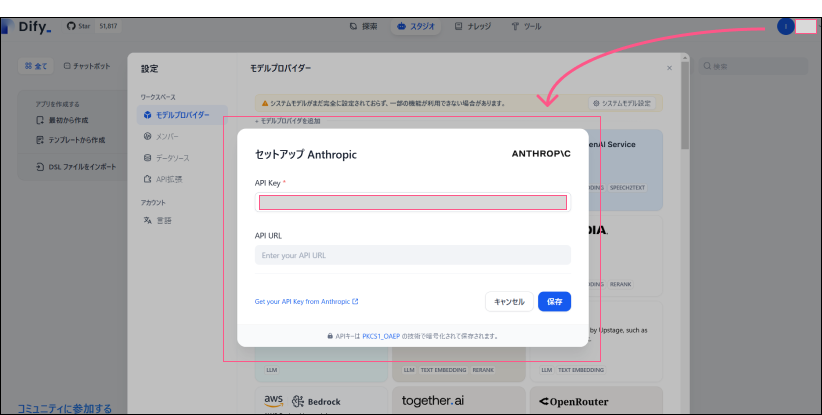

Dify での OpenAI の設定

「設定」→「Model Provider」

APIキーのみを入力

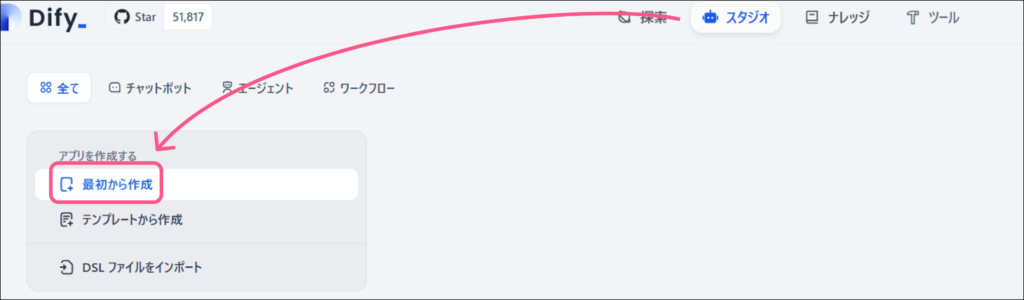

チャットボット作成

Web公開

「公開する」から「ウェブサイトに埋め込む」で下記の通りWeb上にアップできます

注意)Docker起動しておかないと接続はできません

選択肢(1)OpenAI APIキーを使用(Dify標準)

- メリット:

- 設定が簡単

- GPT-4の高性能な応答

- 日本語対応が完璧

- デメリット:

- 質問内容がOpenAIサーバーに送信される

- コストがかかる

- APIキー管理のリスク

選択肢(2)ローカルAIモデル(完全オフライン)

- メリット:

- データが外部に漏れない

- ランニングコストなし

- カスタマイズ可能

- デメリット:

- セットアップが複雑

- 計算リソースが必要

- GPT-4より性能は劣る

Tiny-Llamaとは

- Meta社のLlamaモデルを小型化したバージョン

- オープンソースで商用利用可能

- 元のLlamaの機能を維持しながら、サイズを大幅に縮小

バリエーション

Tiny-Llama-1.1B: 基本モデル

Tiny-Llama-Chat: チャット特化

Tiny-Llama-Code: プログラミング特化必要スペック

最小構成:

- メモリ:4GB以上(8GBのPCで動作可能)

- CPU:一般的なCore i3/i5でOK

- ストレージ:3GB程度の空き容量参考外付けSSD

容量が不足しそうであれば外付けSSD

推奨スペック:

- 容量:最低128GB以上

- タイプ:USB 3.0/3.1以上

- 読み書き速度:500MB/s以上通常のLlama-2: 7GB-70GB

Tiny-Llama: 約1.1GB-2GB

GPT-3: 175GB以上| 容量 | 速度 | 特徴 | |

|---|---|---|---|

| Samsung T7 | 500GB〜2TB | 500MB/s以上 | 信頼性が高く、ポータブルで耐衝撃性もあるため、持ち運びにも適しています。 |

| Sandisk Portable SSD | 250GB〜2TB | 500MB/s以上 | コストパフォーマンスが良く、一般的な使用に十分な性能です。 |

| Crucial X8 | 500GB〜2TB | 1050MB/s以上 | 耐久性が高く、速度も速いので、長期間の使用に向いています。 |

APIキーの設定

- 右上のプロファイルアイコン → Settings をクリック

- 左メニューの「API Keys」を選択

- OpenAI APIキーを入力